Die NVIDIA Blackwell Plattform ist da, um eine neue Ära des Computings einzuleiten

(Übersetzt aus der englischen Presseerklärung)

- Neue Blackwell-GPU, NVLink und Resilience-Technologien ermöglichen KI-Modelle im Trillionen-Parameter-Maßstab.

- Neue Tensor-Kerne und TensorRT-LLM-Compiler reduzieren die Betriebskosten und Energie für LLM-Inferenz um bis zu 25-fach.

- Neue Beschleuniger ermöglichen Durchbrüche in der Datenverarbeitung, Ingenieurssimulation, elektronischen Entwurfsautomatisierung, computergestützten Arzneimitteldesign und Quantencomputing.

- Breite Akzeptanz durch jeden bedeutenden Cloud-Anbieter, Serverhersteller und führendes KI-Unternehmen.

SAN JOSE, Kalifornien, 18. März 2024 (GLOBE NEWSWIRE) — NVIDIA gab heute bekannt, dass die NVIDIA Blackwell Plattform eingeführt wurde und eine neue Ära des Computings einläutet. Damit können Organisationen weltweit Echtzeit-generative KI auf Sprachmodellen mit Billionen Parametern erstellen und ausführen, bei bis zu 25-fach geringeren Kosten und Energieverbrauch im Vergleich zu ihrem Vorgänger.

Die Blackwell GPU-Architektur umfasst sechs transformative Technologien für beschleunigtes Computing, die dazu beitragen werden, Durchbrüche in der Datenverarbeitung, Ingenieurssimulation, elektronischen Entwurfsautomatisierung, computergestützten Arzneimitteldesign, Quantencomputing und generativer KI zu ermöglichen – alles aufstrebende Branchenmöglichkeiten für NVIDIA.

„Seit drei Jahrzehnten verfolgen wir das Ziel des beschleunigten Computings, um transformative Durchbrüche wie Deep Learning und KI zu ermöglichen“, sagte Jensen Huang, Gründer und CEO von NVIDIA. „Generative KI ist die wegweisende Technologie unserer Zeit. Blackwell ist der Motor, der diese neue industrielle Revolution antreibt. In Zusammenarbeit mit den dynamischsten Unternehmen der Welt werden wir das Versprechen von KI für jede Branche verwirklichen.“

Zu den vielen Organisationen, die erwartet werden, Blackwell zu übernehmen, gehören Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla und xAI.

Sundar Pichai, CEO von Alphabet und Google: „Das Skalieren von Diensten wie Suche und Gmail für Milliarden von Nutzern hat uns viel über das Management von Recheninfrastrukturen gelehrt. Da wir in die Plattformverschiebung im Bereich KI eintreten, investieren wir weiterhin stark in Infrastruktur für unsere eigenen Produkte und Dienstleistungen sowie für unsere Cloud-Kunden. Wir sind glücklich, eine langjährige Partnerschaft mit NVIDIA zu haben, und freuen uns darauf, die bahnbrechenden Fähigkeiten der Blackwell-GPU unseren Cloud-Kunden und Teams bei Google, einschließlich Google DeepMind, zur Beschleunigung zukünftiger Entdeckungen zur Verfügung zu stellen.“

Andy Jassy, Präsident und CEO von Amazon: „Unsere enge Zusammenarbeit mit NVIDIA reicht mehr als 13 Jahre zurück, als wir die weltweit erste GPU-Cloud-Instanz auf AWS starteten. Heute bieten wir die breiteste Palette an GPU-Lösungen, die überall in der Cloud verfügbar sind, und unterstützen die technologisch fortschrittlichsten beschleunigten Workloads der Welt. Deshalb wird die neue NVIDIA Blackwell-GPU auf AWS so gut funktionieren, und deshalb hat NVIDIA AWS ausgewählt, um gemeinsam Project Ceiba zu entwickeln, indem die Grace Blackwell Superchips der nächsten Generation von NVIDIA mit der fortschrittlichen Virtualisierung des AWS Nitro-Systems und dem ultraschnellen Netzwerkadapter Elastic Fabric Adapter kombiniert werden, für die eigene KI-Forschung und -entwicklung von NVIDIA. Durch diese gemeinsame Anstrengung zwischen AWS- und NVIDIA-Ingenieuren setzen wir unsere gemeinsame Innovation fort, um AWS zum besten Ort für jeden zu machen, der NVIDIA-GPUs in der Cloud betreiben möchte.“

Michael Dell, Gründer und CEO von Dell Technologies: „Generative KI ist entscheidend für die Schaffung intelligenterer, zuverlässigerer und effizienterer Systeme. Dell Technologies und NVIDIA arbeiten zusammen, um die Zukunft der Technologie zu gestalten. Mit der Einführung von Blackwell werden wir weiterhin die nächste Generation beschleunigter Produkte und Dienstleistungen an unsere Kunden liefern und ihnen die Werkzeuge zur Verfügung stellen, die sie benötigen, um Innovationen in allen Branchen voranzutreiben.“

Demis Hassabis, Mitbegründer und CEO von Google DeepMind: „Das transformative Potenzial von KI ist unglaublich, und es wird uns helfen, einige der wichtigsten wissenschaftlichen Probleme der Welt zu lösen. Die bahnbrechenden technologischen Fähigkeiten von Blackwell werden die für die weltweit hellsten Köpfe benötigte Rechenleistung bereitstellen, um neue wissenschaftliche Entdeckungen zu ermöglichen.“

Mark Zuckerberg, Gründer und CEO von Meta: „KI treibt bereits alles von unseren großen Sprachmodellen bis hin zu unseren Inhaltsempfehlungen, Anzeigen und Sicherheitssystemen an, und sie wird in Zukunft nur noch wichtiger werden. Wir freuen uns darauf, NVIDIA’s Blackwell zu verwenden, um unsere Open-Source-Llama-Modelle zu trainieren und die nächste Generation von Meta KI und Verbraucherprodukten aufzubauen.“

Satya Nadella, Exekutivvorsitzender und CEO von Microsoft: „Wir sind entschlossen, unseren Kunden die fortschrittlichste Infrastruktur für ihre KI-Workloads anzubieten. Indem wir den GB200 Grace Blackwell-Prozessor in unsere Rechenzentren weltweit bringen, bauen wir auf unserer langjährigen Geschichte der Optimierung von NVIDIA-GPUs für unsere Cloud auf, während wir das Versprechen von KI für Organisationen weltweit real machen.“

Sam Altman, CEO von OpenAI: „Blackwell bietet massive Leistungssprünge und wird unsere Fähigkeit, führende Modelle bereitzustellen, beschleunigen. Wir freuen uns darauf, weiterhin mit NVIDIA zusammenzuarbeiten, um KI-Compute zu verbessern.“

Larry Ellison, Vorsitzender und CTO von Oracle: „Die enge Zusammenarbeit von Oracle mit NVIDIA wird qualitative und quantitative Durchbrüche in KI, maschinellem Lernen und Datenanalyse ermöglichen. Damit Kunden mehr handlungsorientierte Erkenntnisse gewinnen können, wird ein noch leistungsstärkerer Motor wie Blackwell benötigt, der speziell für beschleunigtes Computing und generative KI entwickelt wurde.“

Elon Musk, CEO von Tesla und xAI: „Derzeit gibt es nichts Besseres als NVIDIA-Hardware für KI.“

Die neue Architektur, benannt zu Ehren von David Harold Blackwell – einem Mathematiker, der sich auf Spieltheorie und Statistik spezialisierte und der erste schwarze Wissenschaftler war, der in die National Academy of Sciences aufgenommen wurde – folgt der NVIDIA Hopper™-Architektur, die vor zwei Jahren eingeführt wurde.

Blackwell-Innovationen zur Förderung von beschleunigtem Computing und generativer KI

Die sechs revolutionären Technologien von Blackwell, die zusammen das KI-Training und die Echtzeit-LLM-Inferenz für Modelle mit bis zu 10 Billionen Parametern ermöglichen, umfassen:

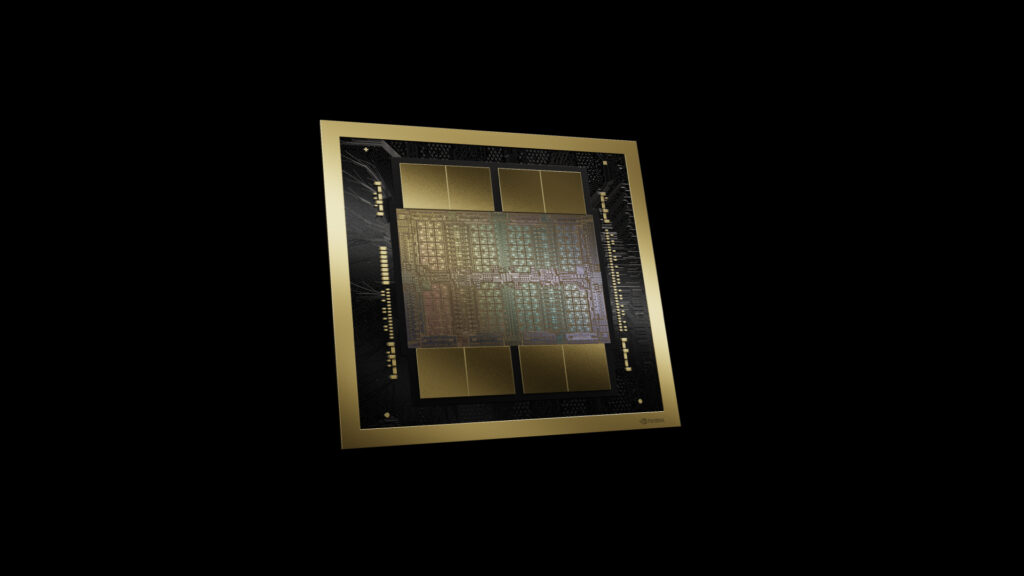

- Weltweit leistungsstärkster Chip – Mit 208 Milliarden Transistoren sind Blackwell-Architektur-GPUs mit einem maßgeschneiderten 4NP-TSMC-Prozess hergestellt, der zwei Reticle-GPU-Dies umfasst, die über eine Chip-zu-Chip-Verbindung mit einer Geschwindigkeit von 10 TB/s zu einer einzigen, vereinheitlichten GPU verbunden sind.

- Zweite Generation des Transformer Engines – Angespornt von der neuen Unterstützung für Mikro-Tensor-Skalierung und den fortschrittlichen Dynamikbereichsmanagementalgorithmen von NVIDIA, integriert in die Frameworks NVIDIA TensorRT™-LLM und NeMo Megatron, wird Blackwell die doppelte Rechenleistung und Modellgrößen mit neuen 4-Bit-Floating-Point-KI-Inferenzfähigkeiten unterstützen.

- Fünfte Generation von NVLink – Um die Leistung für mehrtrillionen-Parameter- und MischexpertInnen-KI-Modelle zu beschleunigen, liefert die neueste Iteration von NVIDIA NVLink® bahnbrechende bidirektionale Durchsatzraten von 1,8 TB/s pro GPU, um eine nahtlose Hochgeschwindigkeitskommunikation zwischen bis zu 576 GPUs für die komplexesten LLMs zu gewährleisten.

- RAS Engine – Blackwell-betriebene GPUs verfügen über einen dedizierten Motor für Zuverlässigkeit, Verfügbarkeit und Dienstbarkeit. Darüber hinaus fügt die Blackwell-Architektur auf Chip-Ebene Fähigkeiten hinzu, um KI-basierte präventive Wartung zur Durchführung von Diagnosen und Vorhersage von Zuverlässigkeitsproblemen einzusetzen. Dies maximiert die Systemverfügbarkeit und verbessert die Widerstandsfähigkeit für massive KI-Bereitstellungen, die wochen- oder sogar monatelang ununterbrochen laufen, und reduziert die Betriebskosten.

- Sichere KI – Fortgeschrittene vertrauliche Rechenfähigkeiten schützen KI-Modelle und Kundendaten, ohne die Leistung zu beeinträchtigen, mit Unterstützung für neue nativen Schnittstellenverschlüsselungsprotokolle, die für datenschutzsensible Branchen wie Gesundheitswesen und Finanzdienstleistungen entscheidend sind.

- Dekompressionsmotor – Ein dedizierter Dekompressionsmotor unterstützt die neuesten Formate und beschleunigt Datenbankabfragen, um die höchste Leistung in der Datenanalyse und Datenwissenschaft zu liefern. In den kommenden Jahren wird die Datenverarbeitung, für die Unternehmen jährlich Milliarden von Dollar ausgeben, zunehmend durch GPUs beschleunigt werden.

Ein massiver Superchip

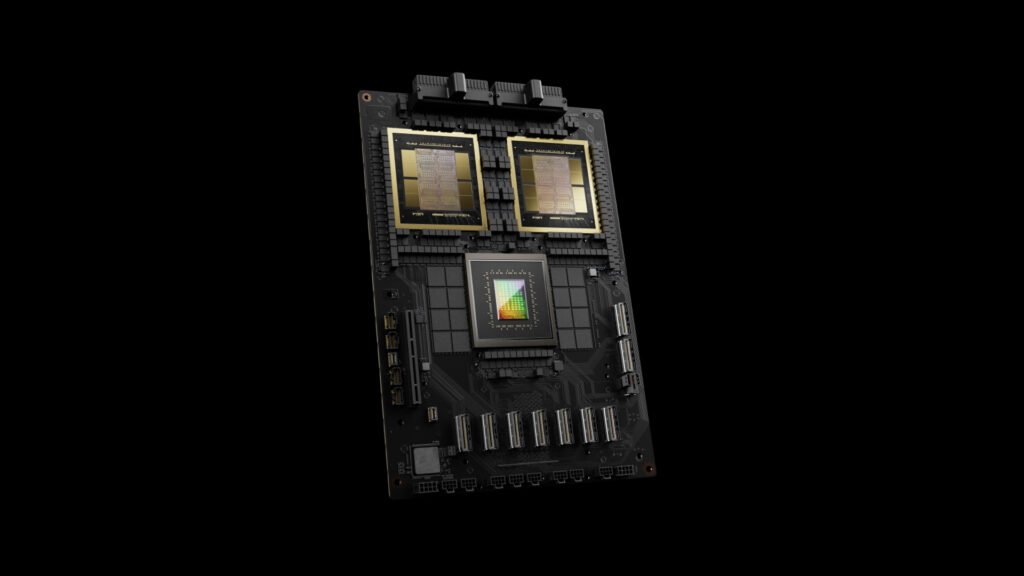

Der NVIDIA GB200 Grace Blackwell Superchip verbindet zwei NVIDIA B200 Tensor Core GPUs über eine 900 GB/s ultra-niedrigenergie NVLink Chip-zu-Chip-Verbindung mit der NVIDIA Grace CPU.

Für die höchste KI-Leistung können GB200-betriebene Systeme mit den heute ebenfalls angekündigten NVIDIA Quantum-X800 InfiniBand- und Spectrum™-X800 Ethernet-Plattformen verbunden werden, die fortschrittliche Netzwerkfähigkeiten mit Geschwindigkeiten von bis zu 800 Gb/s bieten.

Der GB200 ist ein Schlüsselelement des NVIDIA GB200 NVL72, eines multi-node, flüssigkeitsgekühlten, rackfähigen Systems für die anspruchsvollsten Workloads. Es kombiniert 36 Grace Blackwell Superchips, die 72 Blackwell GPUs und 36 Grace CPUs enthalten, die über NVLink der fünften Generation miteinander verbunden sind. Zusätzlich umfasst GB200 NVL72 NVIDIA BlueField®-3 Datenverarbeitungseinheiten, um Cloud-Netzwerkbeschleunigung, komponierbare Speicherung, Null-Vertrauen-Sicherheit und GPU-Computelelastizität in Hyperscale-KI-Clouds zu ermöglichen. Der GB200 NVL72 bietet im Vergleich zu derselben Anzahl von NVIDIA H100 Tensor Core GPUs eine bis zu 30-fache Leistungssteigerung für LLM-Inferenz-Workloads und reduziert Kosten und Energieverbrauch um bis zu 25-fach.

Die Plattform fungiert als einzelne GPU mit 1,4 Exaflops an KI-Leistung und 30 TB schnellem Speicher und ist ein Baustein für den neuesten DGX SuperPOD.

NVIDIA bietet das HGX B200, eine Serverplatine, die acht B200 GPUs über NVLink verbindet, um x86-basierte generative KI-Plattformen zu unterstützen. HGX B200 unterstützt Netzwerkgeschwindigkeiten von bis zu 400 Gb/s über die NVIDIA Quantum-2 InfiniBand- und Spectrum-X Ethernet-Netzwerkplattformen.