Intel Experience Store München: Wie NPUs den PC neu erfinden

Zwischen Viktualienmarkt und verfärbten Herbstblättern hat Intel in München für ein paar Wochen die Zukunft in einen Pop-up-Store gepackt. Wer durch die Glasfront blickt, sieht nicht nur Notebooks und Desktops – man sieht Workflows. Dinge, die früher nur mit Cloud-Diensten oder teuren Workstations möglich waren, laufen plötzlich nativ auf schlanken Laptops. Der gemeinsame Nenner: NPU-Kerne (Neural Processing Units), also spezialisierte Beschleuniger für KI-Aufgaben, die seit der jüngsten Prozessorgeneration in vielen Systemen stecken.

Im Folgenden nehme ich dich mit durch den Store, die Demos und – viel spannender – durch die konkreten Anwendungsfälle: Adobe Photoshop und Premiere Pro, lokale Bildgenerierung per Prompt, Sicherheit durch On-Device-Analyse von Bildschirm- und Eingabeinhalten sowie ein smarter Teleprompter von Elgato (Corsair), der endlich mit dem Sprecher statt gegen ihn arbeitet. Unterwegs gibt’s Kommentare aus Gesprächen im Store, kurze Einschübe aus der Praxis und ein paar Zitate, die den Tag in München gut einfangen.

„Das fühlt sich an wie ein stiller Turbolader im Laptop“, meinte ein Besucher und deutete auf die NPU-Auslastungsanzeige neben dem Video-Preview. Genau darum geht’s: Leistung, die man nicht hört – und kaum am Akku merkt.

Was ist eine NPU – und warum sollte mich das interessieren?

CPUs sind vielseitig, GPUs sind massiv parallel – und NPUs sind auf genau die Berechnungen optimiert, die moderne KI-Modelle ständig brauchen: Matrix-Multiplikationen, Vektoroperationen, quantisierte Inferenz bei niedriger Präzision (INT8/INT4) und Workloads mit deterministischen Datenflüssen. Aus der Praxis resultieren drei handfeste Vorteile:

- Effizienz: Für dieselbe KI-Aufgabe braucht die NPU viel weniger Energie als CPU oder GPU. Das bedeutet längere Akkulaufzeit und kühlere Geräte.

- Konstanz: NPUs liefern planbare Latenzen – ideal für Features, die in Echtzeit reagieren müssen (z. B. Sprach- oder Blickverfolgung).

- Freiheit: CPU und GPU bleiben für den „Rest“ frei (Timeline-Scrubbing, Masken, Effects), während die NPU die KI-Inferenz übernimmt.

Der Store macht das elegant sichtbar: Viele Demos zeigen Live-Graphs – CPU, GPU, NPU – und wie die Last zwischen den Einheiten aufgeteilt wird. Es ist das erste Mal, dass man als Endanwender so klar sieht, wo die Magie im Gerät wirklich passiert.

Photoshop mit NPU-Unterstützung: KI, die sich wie ein normales Werkzeug anfühlt

Adobe hat in Photoshop in den letzten Jahren mächtig Gas gegeben: Generative Füllung, kontextbewusste Retuschen, semantische Auswahlen. Das Überraschende in München war nicht, dass diese Funktionen existieren. Das Überraschende war, wie natürlich sie mit NPU-Unterstützung wirken.

Vereinfachung der Bildmanipulation

Die klassische Retusche – Stempel, Pinsel, Ebenenmasken – bleibt wichtig. Aber: Ein „Prompt-Pinsel“ mit ein paar Worten wie „Füge einen weichen, warmen Abendhimmel hinter das Gebäude, leicht bewölkt“ erzeugt in Sekunden einen glaubhaften Hintergrund, der in die Perspektive passt und die Lichtsituation respektiert.

- Kontextverständnis: Die NPU beschleunigt die Objekt- und Kantenanalyse. Personen, Himmel, Stoffe, Wasserflächen – alles lässt sich mit einem Klick sinnvoll separieren.

- Iteratives Arbeiten: Statt „alles oder nichts“ bekommt man Varianten. Wenn ein Vorschlag nicht passt, generiert man lokal die nächste – ohne Upload, ohne Wartezimmer-Cloud.

Kommentar aus dem Gespräch mit einem Creator vor Ort: „Ich habe mich früher oft zwischen schnell und gut entscheiden müssen. Jetzt ist schnell plötzlich auch gut genug – und gut ist in fünf Iterationen erreichbar.“

Warum On-Device?

Zwei Gründe: Privatsphäre und Zeit. Bilder verlassen den Rechner nicht; Kundendaten bleiben intern. Gleichzeitig fallen Latenzen weg, die bei vielen kleinen Iterationen nerven. Und der Akku? Bleibt entspannt, weil die NPU mit minimaler Leistungsaufnahme inferenziert.

Premiere Pro: Videos nach „blauer Jacke“ oder „Wasser“ durchsuchen

Das Highlight für Cutterinnen und Cutter war eine Beta-Demo in Adobe Premiere Pro: Die Software analysiert importierte Clips semantisch und macht sie durchsuchbar – nicht nur nach gesprochenen Wörtern, sondern nach visuellen Features: „blaue Jacke“, „Wasser“, „Hund am Strand“, „Nachtszene mit Neonlicht“.

Wie fühlt sich das an?

Du ziehst einen Ordner mit 200 Clips ins Projekt. Im Hintergrund läuft eine On-Device-Analyse: Objekterkennung, Szene-Klassifikation, vielleicht sogar einfache Tätigkeits-Labels. Anschließend tippst du in ein Suchfeld „blau Jacke Wasser“ – und Premiere zeigt dir Trefferlisten samt Mini-Thumbnails an der richtigen Stelle in der Timeline.

- NPU-Vorteil: Die Erkennung läuft bei moderatem Stromverbrauch parallel zum Sichten. Der Rechner bleibt bedienbar; der Lüfter bleibt leise.

- Workflow-Vorteil: Statt sichten → markieren → benennen, startet man sofort in die inhaltliche Montage.

„Ich habe mein Archiv in meinem Kopf – aber nicht in meiner Timeline“, scherzte ein Cutter neben mir. „Wenn die Maschine mir die ersten Schubladen sortiert, finde ich schneller die kreativen Übergänge.“

Nativ auf dem Computer: Bildgenerierung per Prompt (ohne Cloud)

Im Store lief eine Reihe kleiner lokaler Diffusion- und LLM-Demos. Die Kernidee: Basismodelle werden quantisiert (z. B. INT8/INT4), auf die NPU angepasst und laufen dann direkt auf dem Notebook. Du tippst „cinematisches Porträt in Abendlicht, 85-mm-Look, weiche Tiefenunschärfe“, wartest ein paar Sekunden – fertig. Kein Konto, keine Uploads, keine Serverkosten.

Grenzen & Chancen

- Qualität: Absolute Spitzenqualität großer, unbegrenzter Cloud-Modelle wird lokal (noch) nicht immer erreicht. Für Moodboards, Mockups, schnelle Varianten reicht es oft locker.

- Geschwindigkeit: Für Ideation-Phasen sind 3–10 Sekunden pro Bild Gold wert – insbesondere ohne Kontextwechsel in den Browser.

- Privatsphäre & IP: Interne Designs, Logos, sensible Produktshots bleiben im Haus. In manchen Branchen ist das der Hauptgrund für On-Device-KI.

Ein Ingenieur fasste es so zusammen:

„Viele Unternehmen haben weniger ein Technik-, sondern ein Risikoproblem. On-Device nimmt unzählige Fragezeichen aus der Gleichung.“

Sicherheit: Inhalte und Eingaben lokal prüfen (NSFW & gesperrte Begriffe)

Ein weiterer Abschnitt im Store widmete sich Content Safety – nüchtern, aber hochrelevant. Zwei Szenarien:

- Bildschirm-Analyse nach NSFW-Inhalten Die NPU klassifiziert laufend Frames aus dem Bildschirmpuffer. Wird ein Schwellenwert überschritten, kann der Rechner z. B. automatisch sperren, Pixel verfremden oder die IT benachrichtigen (je nach Policy). Das richtet sich nicht nur an Jugendschutz, sondern auch an unternehmensweite Compliance.

- Eingabe-Analyse Texteingaben werden lokal auf sensible oder gesperrte Begriffe geprüft: personenbezogene Daten, interne Projektnamen, anstößige Wörter, Social-Engineering-Trigger. Anders als klassische Keyword-Listen können moderne Modelle Kontext berücksichtigen („dürfen“, „nicht dürfen“, Ironie, Zitate).

Warum das lokal Sinn ergibt

- Datenschutz: Weder Bildschirminhalte noch Tastatureingaben verlassen das Gerät.

- Reaktionszeit: Schutzmechanismen greifen ohne Roundtrip in die Cloud.

- Anpassbarkeit: Unternehmen können eigene Regeln hinterlegen – inklusive unterschiedlicher Sensibilität pro Abteilung.

Natürlich ist das ein heikles Thema. Wer überwacht wen – und wie transparent ist das? Wichtig ist, dass Policy und Kommunikation Hand in Hand gehen. Technisch ist die On-Device-Prüfung jedenfalls die datensparsamste Variante.

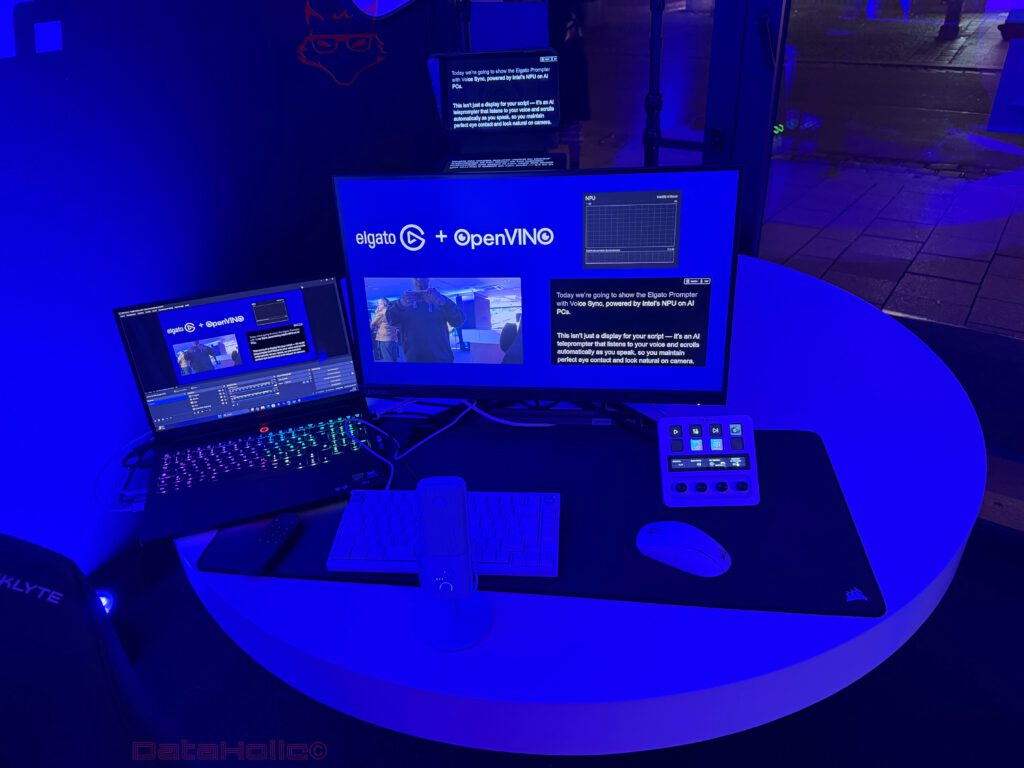

Elgato Prompter + OpenVINO: Der Teleprompter, der zuhört

Ein Publikumsmagnet war die Ecke von Elgato (Corsair): ein Teleprompter, der nicht mehr die starre Instanz vorne am Pult ist, sondern aktives Gegenüber. Die Demo zeigte „elgato + OpenVINO“ auf dem Screen; daneben Grafiken zur NPU-Auslastung. Der Trick:

- Das System hört dem Sprecher in Echtzeit zu (On-Device-Spracherkennung).

- Es bewegt den Script-Text in der Geschwindigkeit des Sprechers.

- Pausen? Atmer? Ad-lib-Einschübe? Der Text wartet.

- Ziehst du das Tempo an, scrollt der Text mit.

Früher galt: Der Mensch passt sich dem Prompter an. Jetzt gilt: Der Prompter passt sich dem Menschen an.

Das verändert mehr als man denkt:

- Natürlichkeit: Sprecher halten Blickkontakt zur Kamera, statt hektisch zu scannen.

- Fehlertoleranz: Versprecher sind kein Drama. Der Text „springt“ nicht weg.

- Solo-Setups: Eine Einzel-Creatorin kann hochwertige Takes ohne Operator produzieren.

Ein Creator im Store brachte es trocken auf den Punkt: „Endlich kann ich reden wie ein Mensch – und nicht wie ein Metronom.“

Technisch stützt sich die Lösung auf OpenVINO-Optimierungen und NPU-beschleunigte Inferenz für ASR (Automatic Speech Recognition) plus Takt-/Tempo-Ableitung. CPU und GPU bleiben frei für Vorschau, Farbkorrektur, Capture-Software oder Streaming.

Praxisblick: Was bedeuten NPUs im Alltag?

1) Akkulaufzeit & Lautstärke

Die vielleicht spürbarste Änderung: Kreativ- und Office-Workflows mit KI-Elementen werden leiser. Der Lüfter bleibt öfter aus, weil die NPU pro Watt deutlich mehr Inferenz schafft. Wer unterwegs generiert, transkribiert oder klassifiziert, kommt merklich länger ohne Steckdose aus.

2) „Nebenbei-KI“

Weil die NPU dediziert ist, kann KI endlich nebenbei laufen, ohne das System zu verstopfen. Beispiele:

- Live-Rauschunterdrückung und Sprechertrennung im Call, während du in Figma arbeitest.

- Bildschirm-OCR und semantische Suche, während du recherchierst.

- Automatische B-Roll-Vorschläge beim Sichten – ohne Ruckeln in der Timeline.

3) Datenschutzfreundliche Workflows

Gerade in Deutschland ist das oft das Zünglein an der Waage. On-Device-KI ist juristisch einfacher zu verantworten als dauerhafte Cloud-Uploads. Das senkt Hürden für KI-Rollouts in KMU und Behörden.

4) Neues Skill-Set

Wer das Maximum will, lernt zwei Dinge:

- Prompts präzise formulieren (Stil, Licht, Objektive, Tonalität).

- Modelle & Presets wählen, die zur Aufgabe passen (z. B. feinere Upscaler vs. schnelle Draft-Modelle).

Merksatz aus einem Workshop-Schnipsel: „Nicht mehr klicken, sondern besser beschreiben.“

Ein Rundgang durch den Store (Eindrücke)

- Notebook-Strecke: Eine Reihe aktueller Geräte – vom ultradünnen 2-in-1 bis zum Creator-Laptop. Viele Systeme zeigen rechts unten ein kleines Overlay mit NPU-, CPU- und GPU-Last. Das macht die abstrakte Architektur greifbar.

- Creator-Insel: Monitor, Kamera, Mikro, Stream-Deck, Teleprompter. Hier wird klar: NPUs sind kein Selbstzweck, sondern machen Setups einfacher. Weniger Kästchen, weniger Lärm, mehr Kontrolle im Gerät.

- Gaming-Ecke: Ja, auch hier spielt KI rein – etwa bei Upscaling oder bei Tools, die Highlights erkennen und automatisch Clip-Marker setzen. Gaming bleibt GPU-Land, aber die Peripherie-KI (Analyse, Assistenz, Automatisierung) zieht ein.

Ein Detail am Rande: Der Store ist hands-on gedacht. Wer will, tippt selbst Prompts, dreht am Prompt-„Vokabular“, vergleicht Varianten. Das ist wichtig, weil man die Stärken und Grenzen nur spürt, wenn man selbst iteriert.

Chancen, Grenzen, nächste Schritte

- Chancen

- Demokratisierung: Features, die früher Profi-Setups vorbehalten waren, landen in der Breite.

- Sicherheit: NSFW- und Eingabe-Analyse On-Device ist ein pragmatischer Weg, Schutz und Datenschutz zusammenzubringen.

- Kreativität: Schnellere Iterationen verändern, wie man auf Ideen kommt. Wer in fünf Minuten zehn visuelle Richtungen testet, entscheidet anders.

- Grenzen

- Modellgröße: Manche State-of-the-Art-Modelle sind lokal (noch) zu groß oder zu langsam.

- Qualitätsstreuung: Nicht jede lokale Generierung trifft auf Anhieb das Niveau großer Cloud-Backends.

- Ökosystem: Die besten Ergebnisse entstehen, wenn Software-Hersteller NPU-Wege gezielt nutzen – der Ball liegt also auch bei Adobe & Co.

- Nächste Schritte

- Hybrid denken: Lokale Inferenz für den Alltag, Cloud für Spezialfälle.

- Policies definieren: Wenn Bildschirm- oder Eingaben-Analyse genutzt wird, braucht es klare, transparente Regeln.

- Teams schulen: Prompting, Presets, Modellwahl – kleine Skills mit großer Wirkung.

Mini-How-To: So startest du morgen mit NPU-Workflows

- Treiber & Runtimes aktualisieren (inkl. OpenVINO/DirectML/ONNX Runtime, je nach Tool).

- Apps auf NPU-Support checken (Photoshop-/Premiere-Versionen, Settings für „AI on device“).

- Lokale Modelle einrichten (quantisierte Varianten für Bild- oder Sprachaufgaben).

- Eigene Prompts bauen:

- Stilvokabeln (cinematic, soft light, 85 mm look, volumetrisch)

- Inhaltsvokabeln (Objekte, Farben, Stimmung)

- Constraints (realistisch, nicht karikaturesk, keine Schrift)

- Policies (optional): Begriffe, die geblockt oder markiert werden sollen; Schwellenwerte für NSFW; Logging-Regeln.

Tipp: Baue dir eine Prompt-Bibliothek wie eine Pinsel-Sammlung in Photoshop – kurze, präzise Bausteine statt Romanen.

Fazit: Leise Revolution, großer Effekt

Der Intel Pop-Up-Store in München zeigt keine spektakulären Zaubertricks – sondern Alltag, der plötzlich mühelos wird. Die NPU-Kerne sind das fehlende Zahnrad, das KI-Funktionen dorthin bringt, wo sie hingehören: in die Tools, die wir sowieso benutzen.

- In Premiere Pro wird Videomaterial semantisch durchsuchbar – ein Gamechanger für große Archive.

- Bildgenerierung passiert nativ am Rechner – ideal für Entwürfe, Moodboards, vertrauliche Inhalte.

- Sicherheitsfeatures wie NSFW-Screening und Eingabe-Filter laufen lokal – Datenschutz inklusive.

- Und der Elgato-Teleprompter zeigt exemplarisch, wie „Echtzeit + NPU“ Dinge menschlicher macht: Der Text folgt der Stimme, nicht umgekehrt.

Vielleicht beschreibt es dieses Zitat am besten – aufgeschnappt, als zwei Besucher den Store verließen:

„Früher fühlte sich KI an, als müsste ich zu ihr gehen. Jetzt ist sie einfach da, in meinen Programmen, und arbeitet still mit.“

Genau so war der Eindruck in München: kein Feuerwerk, sondern gründliche Handarbeit in Silizium, die Kreativen, Studierenden, IT-Pros und Unternehmen die tägliche Reibung nimmt. Wenn diese Richtung hält, wird 2026 weniger von neuen Buzzwords geprägt sein – und mehr von ruhigeren Lüftern, längeren Akkus und Workflows, die fließen.